评测数据 (多任务协同)

PASCAL-Context

数据描述:

PASCAL-Context是多任务协同任务的常用数据集,包含了10,103个成对的原始图像与数据标注,其中数据标注涵盖了语义分割、人体部分分割、显著性检测、表面法线估计四种任务。训练集、验证集和测试集分别包含4,998、2,607、2,498个样本。

数据集构成和规范:

数据量:

源数据集分成训练集(4,998),验证集(2,607),测试集(2,498)

评测数据量:

评测数据为测试集中的5,000个测试样例

源数据格式:

原图:RGB图

含有语义等信息的标注图

数据集样例:

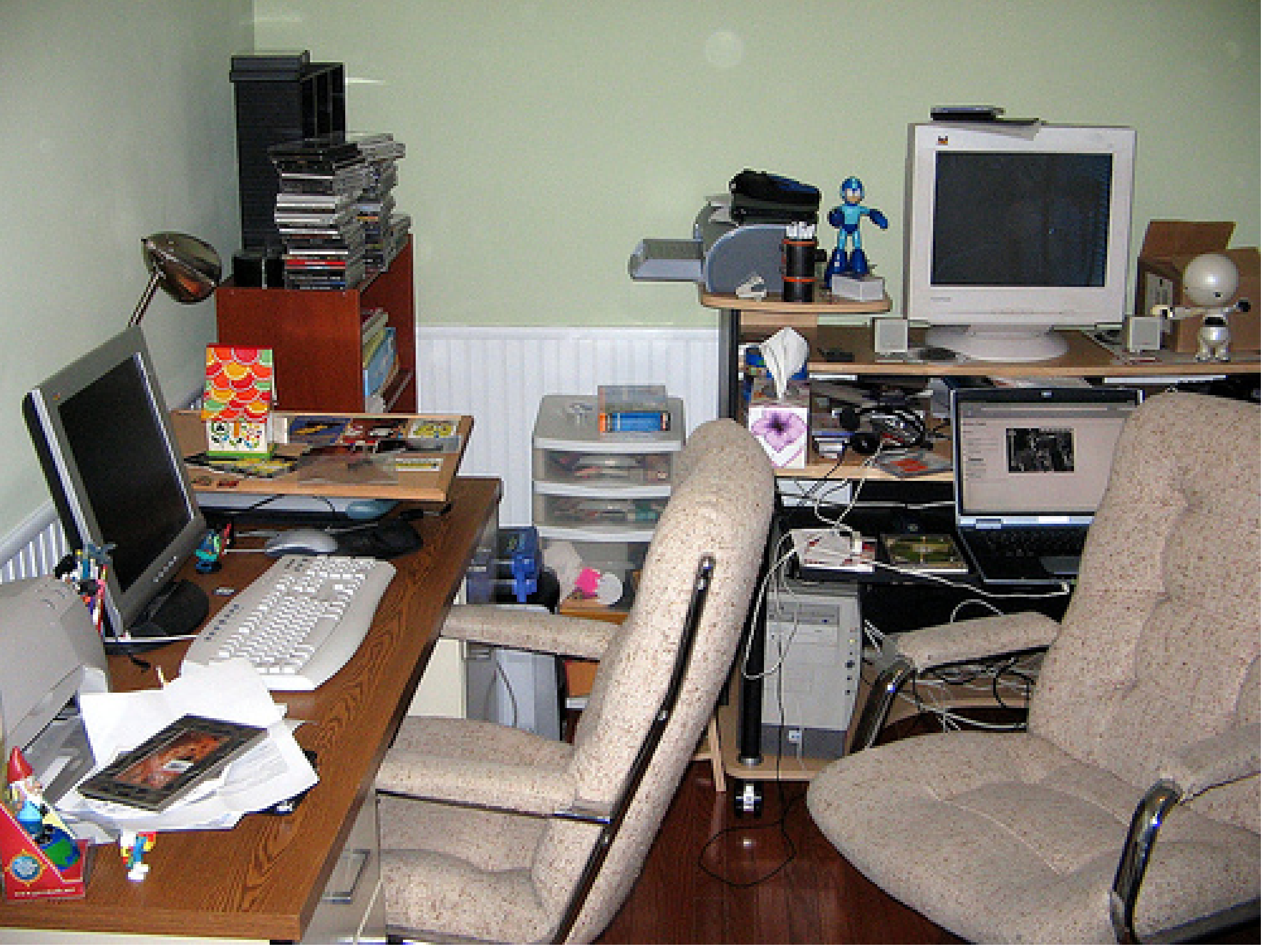

原图:

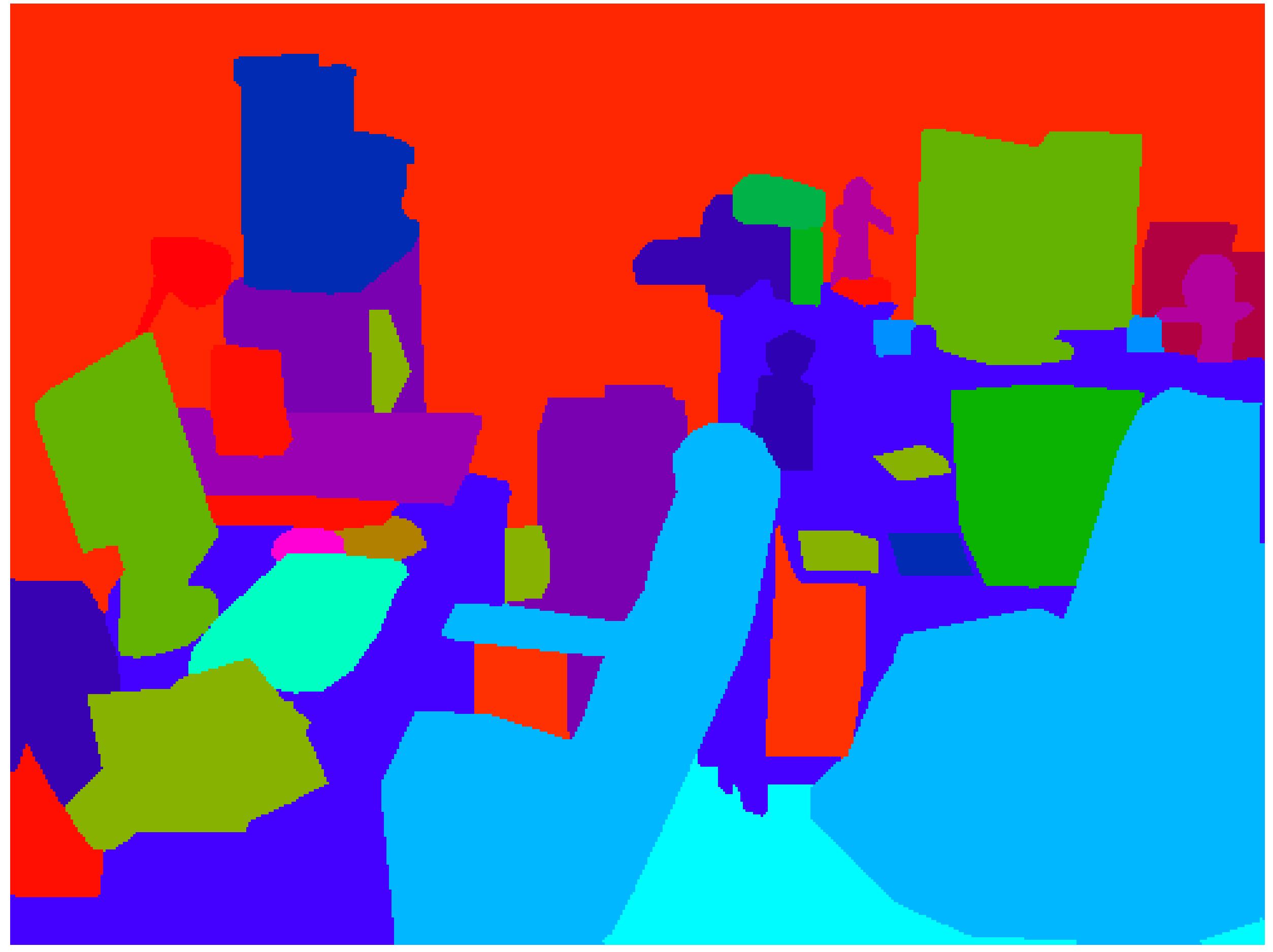

标注图:

论文引用:

@InProceedings{mottaghi_cvpr14,

author = {Roozbeh Mottaghi and Xianjie Chen and Xiaobai Liu and Nam-Gyu Cho and Seong-Whan Lee and Sanja Fidler and Raquel Urtasun and Alan Yuille},

title = {The Role of Context for Object Detection and Semantic Segmentation in the Wild},

booktitle = {IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

year = {2014},

}数据集版权使用说明:

NYUDv2

数据描述:

NYUDv2数据集由来自各种室内场景的视频序列组成。数据集的采集地点十分丰富,包含了3个城市的464个室内场景。NYUDv2数据集包含1,449个成对的原始图像与数据标注,其中数据标注涵盖了语义分割、深度估计、表面法线估计四种任务。训练集、验证集和测试集分别包含795、327、327个样本。

数据集构成和规范:

数据量:

数据集分成训练集(795),验证集(327),测试集(327)

评测数据量:

评测数据为测试集中的327个测试样例

源数据格式:

原图:RGB图

含有语义等信息的标注图

数据集样例:

原图:

标注图:

论文引用:

@inproceedings{Silberman:ECCV12,

author = {Nathan Silberman, Derek Hoiem, Pushmeet Kohli and Rob Fergus},

title = {Indoor Segmentation and Support Inference from RGBD Images},

booktitle = {ECCV},

year = {2012}

}数据集版权使用说明:

Taskonomy

数据描述:

Taskonomy原始数据集包含来自537个不同建筑物的超过460万张室内场景图像。考虑到视觉基础模型的评测效率,选取语义分割与深度估计两个评测任务,其训练集、验证集和测试集分别包含3,785、2,840、2,839个样本。

数据集构成和规范:

数据量:

源数据集分成训练集(3,785),验证集(2,840),测试集(2,839)

评测数据量:

评测数据为测试集中的2,839个测试样例

源数据格式:

原图:RGB图

含有语义等信息的标注图

数据集样例:

原图:

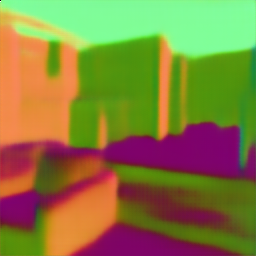

标注图:

论文引用:

@inproceedings{taskonomy2018,

title={Taskonomy: Disentangling Task Transfer Learning},

author={Amir R. Zamir and Alexander Sax and William B. Shen and Leonidas J. Guibas and Jitendra Malik and Silvio Savarese},

booktitle={IEEE Conference on Computer Vision and Pattern Recognition (CVPR)},

year={2018},

organization={IEEE},

}数据集版权使用说明:

VKITTI2

数据描述:

VKITTI2数据集是一个虚拟的自动驾驶场景数据集,它通过高精度的计算机图形技术,模拟了市区、乡村和高速公路等多种驾驶场景以及晴天、雨天、雾天等多种天气条件。VKITTI2数据集具有高度仿真、多样性和标注信息详细等特点,在自动驾驶和计算机视觉领域具有广泛的应用前景。考虑到视觉基础模型的评测效率,选取语义分割与深度估计两个任务,其训练集、验证集和测试集分别包含8,510、4,230、8,520个样本。

数据集构成和规范:

数据量:

源数据集分成训练集(8,510),验证集(4,230),测试集(8,520)

评测数据量:

评测数据为测试集中的5,000个测试样例

源数据格式:

原图:RGB图

含有语义等信息的标注图

数据集样例:

原图:

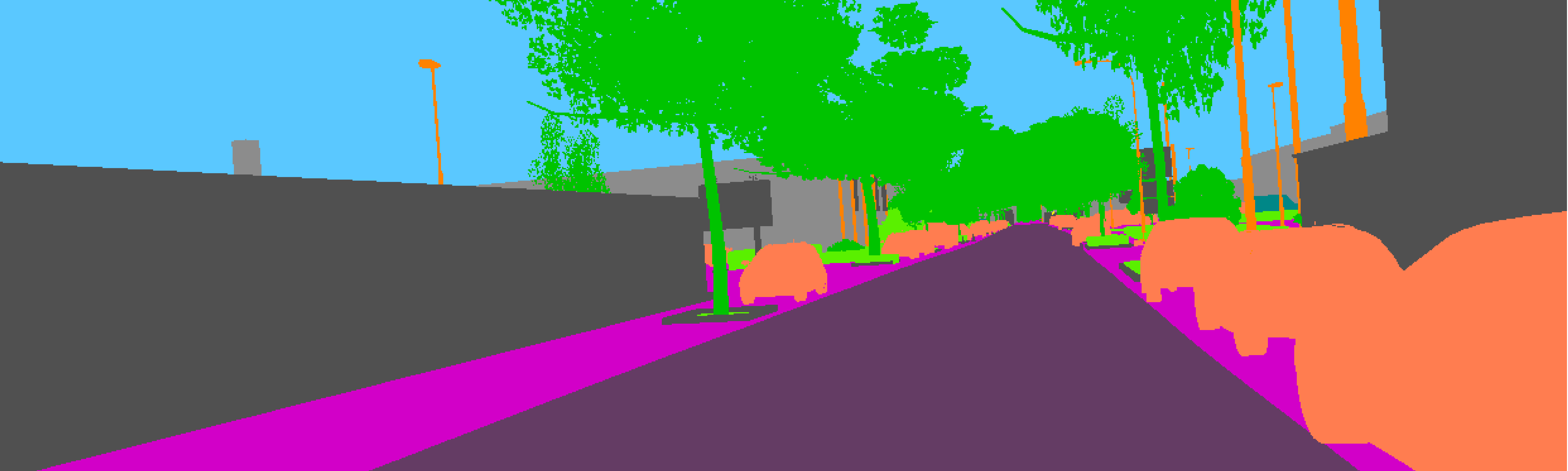

标注图:

论文引用:

@misc{cabon2020vkitti2,

title={Virtual KITTI 2},

author={Cabon, Yohann and Murray, Naila and Humenberger, Martin},

year={2020},

eprint={2001.10773},

archivePrefix={arXiv},

primaryClass={cs.CV}

}数据集版权使用说明:

SUN RGB-D

数据描述:

SUN RGB-D数据集是普林斯顿大学公开的一个有关场景理解的大型室内场景数据集,它包含了丰富的室内场景RGB-D(彩色和深度)图像数据。该数据集共包含了10,335个样本,每个样本都包含了彩色图像和深度信息,考虑到视觉基础模型的评测效率,选取语义分割与深度估计两个任务,其训练集、验证集和测试集分别包含2,665、2,620、5,050个样本。

数据集构成和规范:

数据量:

源数据集分成训练集(2,665),验证集(2,620),测试集(5,050)

评测数据量:

评测数据为测试集中的5,050个测试样例

源数据格式:

原图:RGB图

含有语义等信息的标注图

数据集样例:

原图:

标注图:

论文引用:

@inproceedings{song2015sun,

title={Sun rgb-d: A rgb-d scene understanding benchmark suite},

author={Song, Shuran and Lichtenberg, Samuel P and Xiao, Jianxiong},

booktitle={Proceedings of the IEEE conference on computer vision and pattern recognition},

pages={567--576},

year={2015}

}